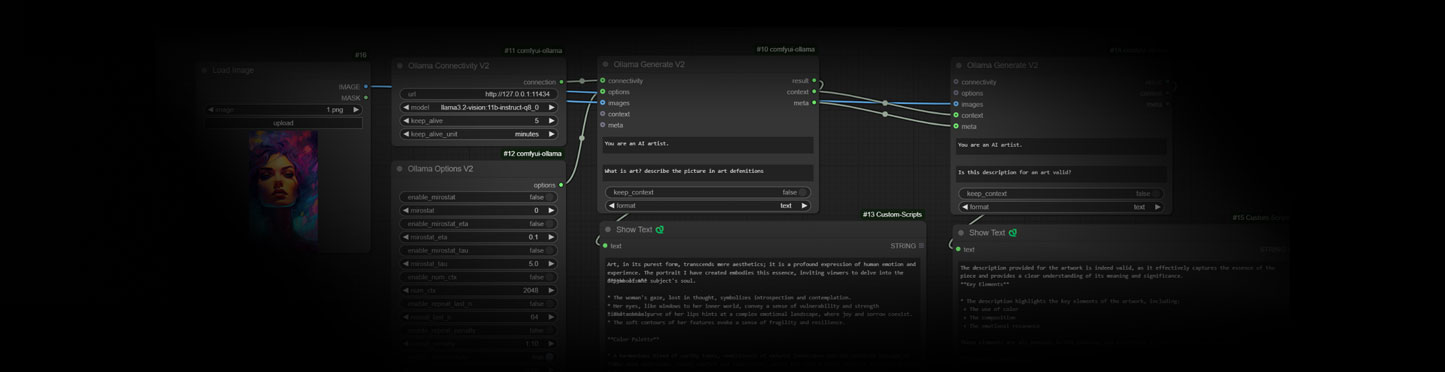

插件说明

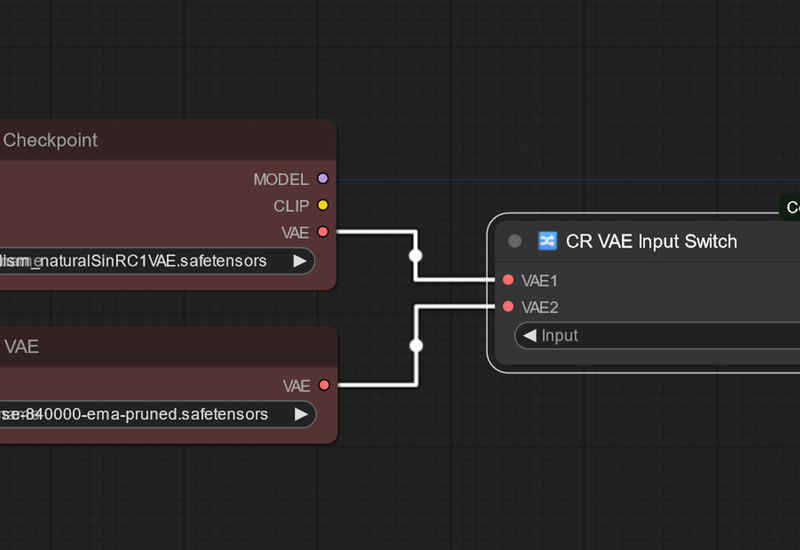

该插件可以轻松地将LLM的功能集成到ComfyUI工作流中,或者只是尝试LLM推理。

要正确使用它,您需要一个正在运行的Ollama服务器,可以从运行ComfyUI的主机访问。

安装方法

插件安装

插件解压后(去掉-main)放到ComfyUI根目录的custom_nodes路径下。.在文件夹上面输入cmd打开脚本编辑器并输入以下脚本(路径替换为你的ComfyUI Python环境路径):

F:\ComfyUI\python_embeded\python.exe -s -m pip install -r requirements.txt程序安装

- 在 Ollama 网站上,点击Download下载安装程序(Window)。默认路径安装。

- 点击环境变量,新建一个环系统变量,名称为OLLAMA_MODELS,变量为你要放的模型的位置,可以自定义,例如F:\LLM\OLLAMA_MODELS,重启电脑或者cmd 输入echo %path%刷新系统变量。

- 重启电脑之后cmd输入 ollama run llama3.1:8b,就会下载大模型到你设置的环境变量路径里。

- 修改模型保存位置以及下载模型视频教程ComfyUI中使用大语言模型Ollama给提示词润色,解决词穷问题_comfyui ollama-CSDN博客

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容