模型介绍

概述

Flux GGUF 版本 是 Flux 模型的一种优化版本,专门为低显存设备设计,能够在显存有限的情况下运行高质量的 AI 图像生成任务。以下是对 Flux GGUF 版本的详细解释:

1. 什么是 GGUF?

GGUF 是 GPT-Generated Unified Format 的缩写,是一种高效的模型存储和交换格式。它通过量化技术(如 4 位、6 位、8 位等)压缩模型权重,从而减少显存占用,同时保持较高的生成质量。

- 量化原理:量化通过减少模型权重的

精度(如从32 位浮点数压缩到4 位),降低显存需求,但可能会略微影响生成质量。 - 优势:GGUF 版本可以在低显存设备(如

6GB 显存)上运行,适合没有高端显卡的用户。

2. 为什么 Flux 需要 GGUF 版本?

Flux 模型的原始版本(如 Flux.1 Dev 和 Schnell)对显存要求较高,通常需要 16GB 或更多的显存才能流畅运行。这对于大多数普通用户来说是一个门槛。GGUF 版本的出现解决了这一问题,使得 Flux 可以在低显存设备上运行。

- 原始版本显存需求:Flux.1 Dev 和 Schnell 的原始版本需要

16GB以上的显存,文件大小通常为23.8GB。 - GGUF 版本显存需求:GGUF 版本通过量化技术,显存需求大幅降低,最低仅需

6GB显存即可运行。

3. GGUF 版本的量化级别

GGUF 版本有多种量化级别,用户可以根据自己的显存大小选择合适的版本:

| 量化级别 | 显存需求 | 生成质量 |

|---|---|---|

| Q2/Q3(2/3 位) | 6GB | 较低 |

| Q4(4 位) | 8GB | 中等 |

| Q5(5 位) | 10GB | 较高 |

| Q8(8 位) | 16GB+ | 接近原始版本 |

- Q4 和 Q5:适合大多数用户,显存需求适中,生成质量较好。

- Q8:适合高端显卡用户,生成质量接近原始版本。

安装方法

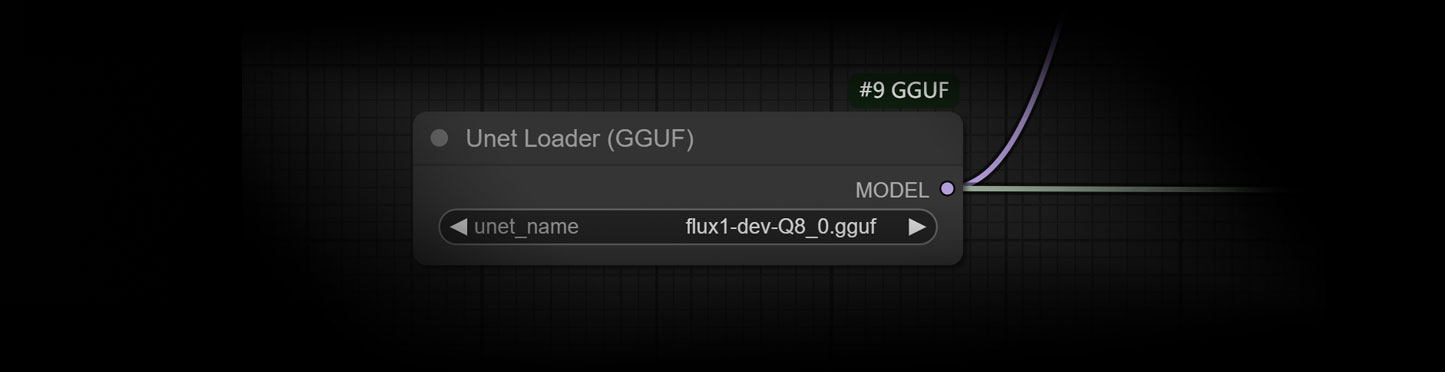

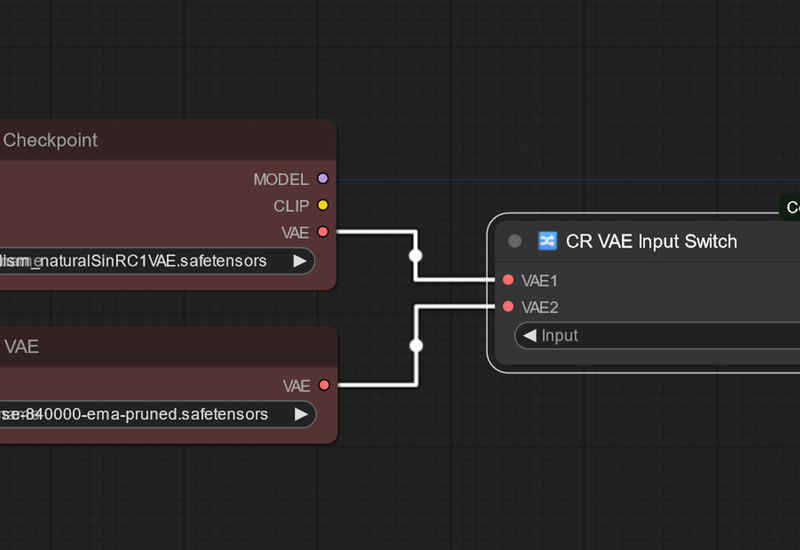

1.需要先安装GGUF插件 ComfyUI-GGUF插件下载-数字折叠

2.选择一个适合配置的gguf模型下载到ComfyUI根目录的models\unet文件夹下

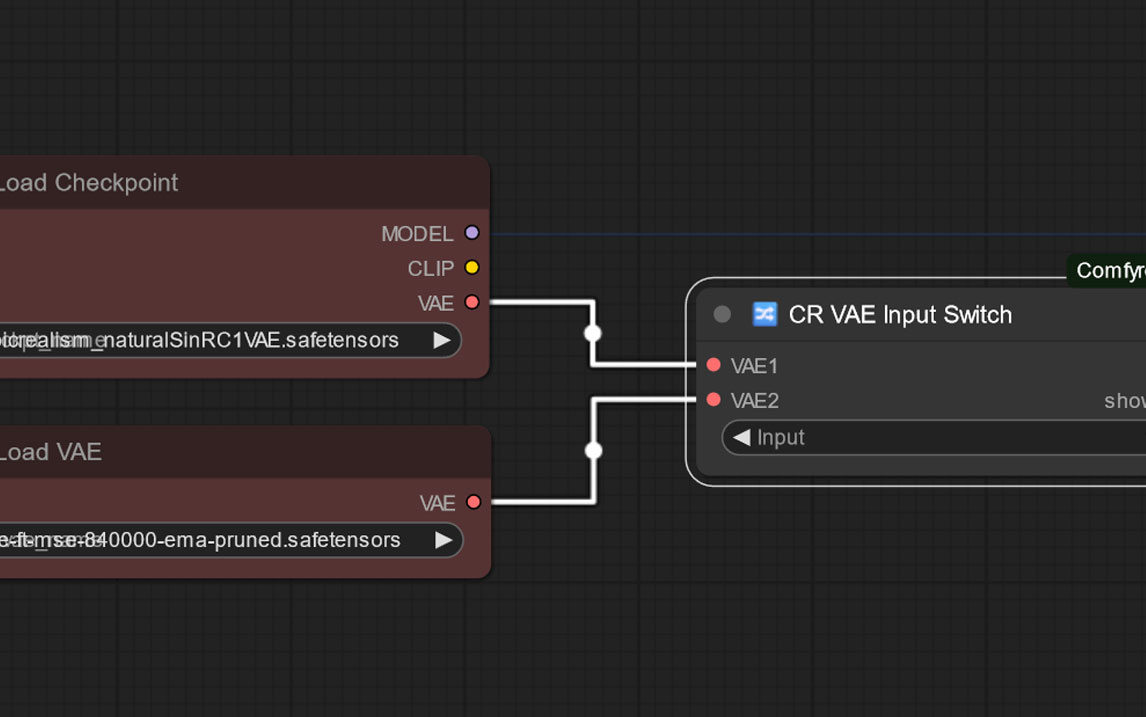

3.两个clip模型放入到ComfyUI根目录的models\clip文件夹下,clip1选择clip_l.safetensors,clip根据你的模型适配选择。

4.vae模型放入到ComfyUI根目录的models\vae文件夹下

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容