模型介绍

2月25日晚间,阿里云旗下视觉生成基座模型万相2.1(Wan)正式开源,此次开源采用最宽松的Apache2.0协议,14B和1.3B两个参数规格的全部推理代码和权重全部开源,同时支持文生视频和图生视频任务。

随后kijai大神随之开发了ComfyUI-WanVideoWrappe插件,保证其可以在Comfyui中进行运行,并且也将相关模型进行量化,本次我们分享的是两款图生视频模型:

- Wan2_1-I2V-14B-480P_fp8_e4m3fn.safetensors

- Wan2_1-I2V-14B-720P_fp8_e4m3fn.safetensors

其他模型可以到Hugging Face下载:Kijai/WanVideo_comfy at main

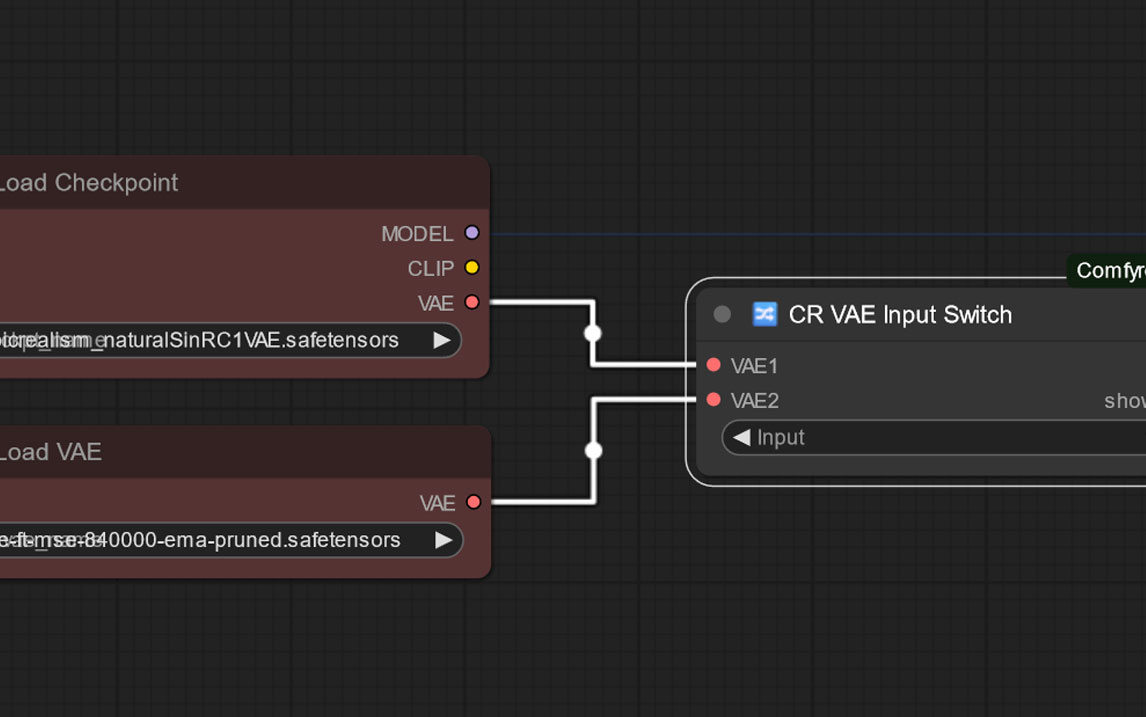

同时模型包内也包含相关适配的vae和clip模型。

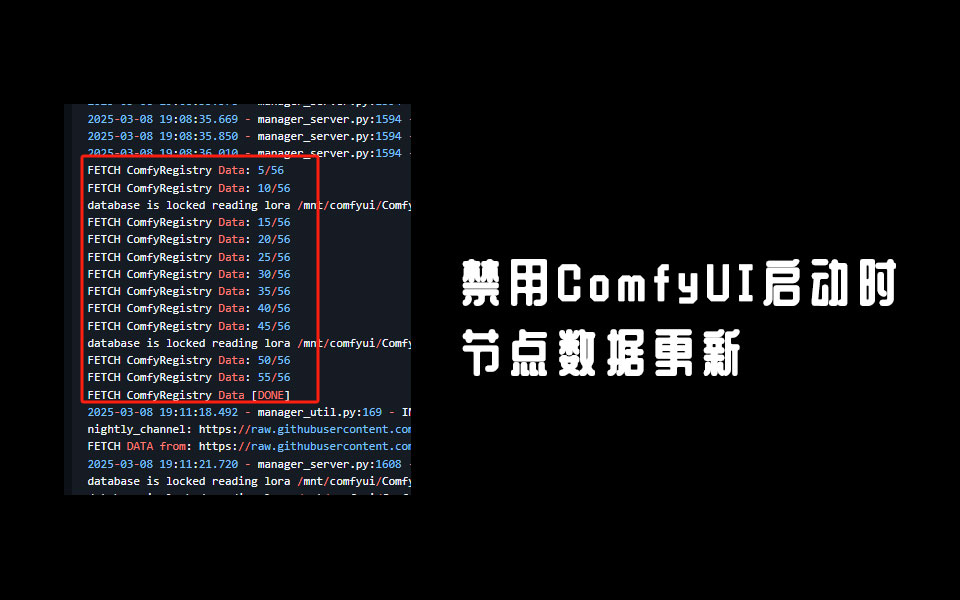

安装方法

- 图生视频模型放到ComfyUI根目录的\models\diffusion_models文件夹内

- clip vision模型放到ComfyUI根目录的models\clip_vision文件夹内

- VAE模型放到ComfyUI根目录的\models\vae文件夹内

- text_encoders模型放到ComfyUI根目录的\models\text_encoders文件夹内

相关工作流可以在ComfyUI-WanVideoWrappe插件包里的example_workflows查看

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容